Wenn die reale Welt mit mathematischen Modellen verschmilzt

Simulationen sind in der Fahrzeugtechnik ein zentraler Baustein für Entwicklung, Fertigung und Test. Heute optimieren dreidimensionale digitale Zwillinge (virtualisierte Modelle von Prozessen und Systemen) die Fabrik- und Materialflussplanung. Hersteller setzen Supercomputer für Augmented Reality (AR) Darstellungen zur Entwicklung und Fertigung von Batterien ein oder verwenden Echtzeit-4D-Simulationen (3D + Zeit) für das Reaktionstraining von Fahrerassistenz Systemen. Die Automobilbranche benötigt dafür High-Performance-Computing (HPC) Lösungen und Highspeed-Netze.

Autos oder rollende Computer?

Virtuelle Fahrzeugmodelle gelten als hochkomplexe Systeme. Sie müssen in Echtzeit auf möglichst realistisch simulierte Umgebungsbedingungen reagieren. In der Regel stammen die entsprechenden Daten aus unterschiedlichsten Quellen und werden an das jeweilige Modell angepasst. Das erfordert eine HPC-Umgebung, die für Big Data und möglichst geringe Latenzen geeignet ist. Dafür nutzen viele Hersteller heute eine Cloud-native Umgebung mit Containern und Micro Services, um zum Beispiel schnell Testfälle für unterschiedliche Simulationen bereitstellen zu können. Damit die IT-Infrastruktur dabei nicht zum Flaschenhals mutiert, benötigen Server, Workstations, Storage und das Netzwerk Highspeed-Verbindungen. Da es sich in der Regel um hochsensible Daten handelt, ist zudem der Rundumschutz vor unbefugtem Zugriff ein Muss. Diese Netze sollten daher nach dem Zero-Trust-Prinzip abgeschirmt sein.

Simulationen ermöglichen neue Technologien

Die aktuellen Trends hin zu elektrischen Antrieben und autonomem Fahren haben große Auswirkungen auf das Fahrzeugdesign und die künftige Ausstattung: Elektrofahrzeuge benötigen weniger Komponenten und Unterbaugruppen, dafür aber möglichst platzsparende Akkus mit großer Reichweite. Zudem werden die Fahrzeuge zunehmend smarter und können mit ihren Fahrerassistenz Systemen somit viel autarker agieren. Dafür brauchen sie KI-basierte, selbstlernende Systeme, die unzählige Sensordaten mit Erfahrungswerten vernetzen können und so das Fahren sicherer gestalten.

Die Umstellung einer Produktion, z.B. von Benzin- auf Elektrofahrzeuge, erfordert eine komplette Umstellung der Fabrik- und Material-Flussplanung. Damit vorhandene Maschinen und Anlagen weiterhin im Einsatz bleiben verwenden viele Hersteller simulierte digitale Zwillinge und versuchen über diese Simulationen, die vorhandenen Anlagen so weit wie möglich in die neuen Fertigungsprozesse einzubinden.

Batterien nach Maß

Damit Akkus in Elektrofahrzeugen künftig weniger Platz einnehmen und solche Lösungen schnell zur Marktreife gelangen, setzen Hersteller heute auf immer komplexere Simulationstechniken. Volkswagen (VW) beispielsweise ging 2017 mit Google eine Kooperation ein, um die chemische Struktur von industrierelevanten Molekülen auf einem Quantencomputer zu simulieren. Die VW-Wissenschaftler des CODE Labs in San Francisco wollen nun auf dieser Basis den chemischen Aufbau eines kompletten Akkus für Elektrofahrzeuge simulieren. Ziel ist es, einen konfigurierbaren chemischen Bauplan direkt in die Fertigung zu liefern, um so Batterien nach Maß herstellen zu können. Mit Simulationen dieser Art hat VW begonnen, sich das Potenzial von Quantencomputern zu erschließen. So plant VW laut einer Presseveröffentlichung im letzten Jahr zum Beispiel mit seinem kalifornischen Batterie-Entwicklungspartner Quantumscape ab 2025 entsprechende Festkörper-Akkus in Salzgitter zu fertigen. Darüber hinaus nutzt VW Quantencomputing für KI-basierte Verfahren des maschinellen Lernens und entwickelt damit damit teil- und hochautomatisierte Fahrfunktionen.

Deep Learning braucht Daten, Daten, Daten – aus realen Testfahrten bitte

Auch Tesla investiert in mehrere Supercomputer, um genügend Rechenkapazitäten für das Deep Learning (DL) seines Autopiloten zur Verfügung zu haben. Experten gehen davon aus, dass neueste DL Technologien nicht mehr über Algorithmen, sondern datengetrieben arbeiten. Entsprechend würden Entwickler künftig Datensätze anpassen. Um die Entscheidungsalgorithmen für autonom fahrende Autos zu trainieren, benötigen die neuronalen Netze ausreichend Daten aus realen Testfahrten, um für praktisch jedes denkbare Szenario ein adäquates Verhaltensmuster hinterlegt zu haben. Somit basieren die Algorithmen nicht mehr auf Image-Dateien, sondern auf Vektoren. Tesla nutzt für die Datensammlung eine Flotte von 1000 Fahrzeugen mit jeweils acht Kameras. Wenn diese Kameras nur eine Stunde lang mit 36 Frames/s die Umgebung filmen, sind das zusammen über eine Milliarde Frames und mehrere Tausend Objekte. Hinzu kommen unzählige Sensordaten, z.B. aus Drehzahl-, Beschleunigungsmessungen und GPS-Daten, die alle im Tesla-Supercomputer gesammelt werden und Metadaten erhalten (sog. Labelling).

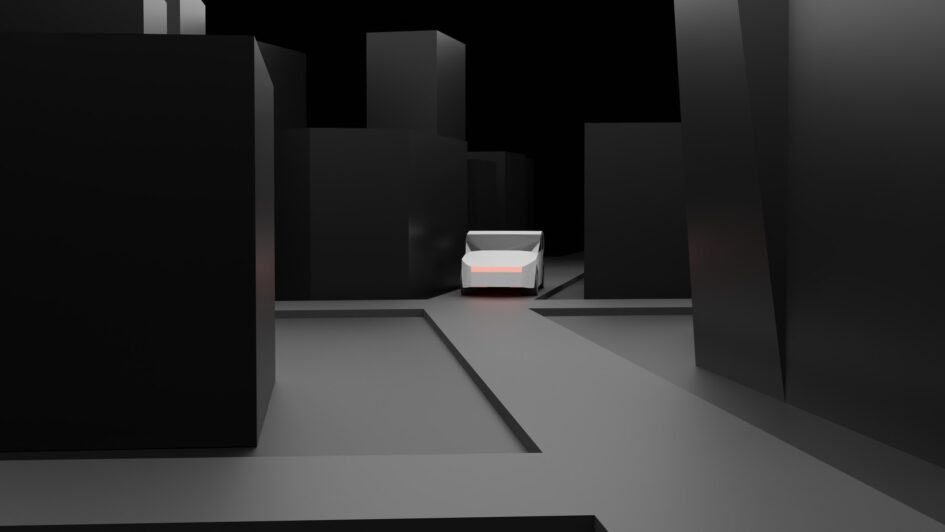

So entstehen daraus 4D-Vektordaten. Labelling ermöglicht zum Beispiel, über weitere Kameraaufzeichnungen des Fahrzeugs oder anderen Fahrzeugen am selben Ort die Straße, Maskierungseffekte und die Kinematik realistisch nachzubauen. Damit DL auch Szenarien berücksichtigt, die mit äußerst geringer Wahrscheinlichkeit auftreten, finden diese Simulationen in den neuronalen 4D-Netzen statt. So trainiert Tesla seinen Autopiloten in einer simulierten Umgebung, die vektorbasiert die Realität so wirklichkeitsnah wie möglich widerspiegelt. Damit soll der Autopilot nahtlos das Gelernte in den späteren Fahrbetrieb übertragen können und für alle denkbaren Vorfälle gerüstet sein.

Sichere Kommunikation vernetzter Fahrzeuge dank Augmented Reality

Ähnliche Simulationen sind auch bei Tests an Fahrerassistenz- und Multimedia Systemen notwendig. Fahrzeuge sind mit immer mehr Kommunikationssystemen ausgestattet, die zuverlässig zusammenspielen müssen und sich keinesfalls gegenseitig stören dürfen. Um das sicherzustellen, wird ein dreidimensionales vektorielles Fahrzeugmodell erzeugt, das die einzelnen Sendequellen mit ihren Antennencharakteristiken enthält. Das versetzt Entwickler in die Lage, in einer vollständig simulierten Umgebung das Sendeverhalten im Fahrzeug zu analysieren und zum Beispiel Einbausituationen zu optimieren. Außerdem lässt sich das Sende- und Empfangsverhalten eines Geräts in einer simulierten Hochfrequenz-Umgebung mit anderen Gerätschaften im Fahrzeug sowie verschiedenen Außenumgebungen untersuchen. Auch hier basieren die verschiedenen Verkehrsszenarien zum Teil aus aufgezeichneten Testfahrten, die sich nach Bedarf anpassen lassen.

So werden die Kommunikationssysteme frühzeitig aufeinander abgestimmt und optimal platziert. Damit bestimmen neue Antriebstechniken sowie die Fahrzeugvernetzung die Gestaltung zukünftiger Fahrzeuge mit. Die Umsetzung erfolgt zunächst über komplexe Simulationen; beginnend von der ersten Designstudie, über alle Entwicklungs- und Testphasen bis zur Fertigung. Diese Simulationen basieren auf einem riesigen Datenpool, aus dem die jeweils benötigten Vektordaten generiert werden.

Das muss Storage bei diesen Augmented-Reality-Anwendungen leisten

Die zugehörige Storage-Lösung der High-Performance-Computing-Umgebung muss die erfassten Sensor- und Videodaten zusammen mit den Metadaten mit möglichst geringer Latenz wegschreiben, damit keine Informationen verloren gehen. Umgekehrt muss der Zugriff auf die jeweiligen Daten für eine 3D- oder auch 4D-Simulation ebenfalls möglichst ohne Latenz erfolgen, damit diese realistisch agiert. Am besten eignet sich hierfür eine Lösung mit einem Hochleistungs-Cache für die Simulationen und ausreichend Festplattenspeicher für die verschiedenen Szenarien, Konfigurationen und Probedurchläufe.